Input-Lag erklärt: So werden Monitor und TV gemessen

Beim Gaming entscheidet jede Millisekunde. Reagiert man zu langsam – egal ob im Shooter oder Autorennen –, ist man verloren. Für TV-Tests messen wir die kritische Verzögerungszeit, bis ein Videosignal an Display oder Projektor ankommt. Doch wie entsteht Input Lag - und wie misst man ihn?

Bei Spielen kommt es besonders auf Präzision und gutes Timing an. Die übliche Reaktionszeit eines Menschen für die Auge-Hand-Koordination beträgt zwischen 200 und 300 Millisekunden. Die wird benötigt, um beispielsweise beim Aufleuchten einer Lampe einen Buzzer zu drücken – ohne nachzudenken....

Bei Spielen kommt es besonders auf Präzision und gutes Timing an. Die übliche Reaktionszeit eines Menschen für die Auge-Hand-Koordination beträgt zwischen 200 und 300 Millisekunden. Die wird benötigt, um beispielsweise beim Aufleuchten einer Lampe einen Buzzer zu drücken – ohne nachzudenken. Gute Gamer bekommen es in kaum mehr Zeit hin, sogar den richtigen Knopf des Joypads zu drücken, um eine koordinierte Aktion auszulösen.

Haben Monitor oder Eingabegerät 100 Millisekunden Verzögerungszeit, bedeutet das einen erheblichen Nachteil, weil man prinzipiell schon getroffen sein kann, bevor man den Hieb sieht. Daher ist teure High-End-Gaming-Hardware auf schnellste Reaktion getrimmt.

Schnell im Heimkino

Bevor Gaming auf Großbildschirmen zum Trend wurde, hat die Latenzzeit im Heimkino relativ wenig ausgemacht. Es war nur minimal nervig, dass Menüknöpfe von Blu-ray- oder DVD-Filmen bis zu einer Viertelsekunde brauchten, um sich nach Drücken der Fernbedienung auch auf dem Display zu bewegen. Während eines Films spielt dieser Zeitverlust erst recht überhaupt keine Rolle mehr.

Hier ist es eher das mit der Panel-Verzögerungszeit einhergehende Problem der Lippensynchronität, das total nerven kann. Gute TV-Geräte speichern ein bis vier Bilder eines Films zwischen, um Bewegungen von Objekten zu analysieren und diese durch Zwischenbilder zu glätten. Ruckler und Flimmern gibt es dann nicht mehr, jedoch kommt das Bild später an. Um das zu kompensieren, verzögern gute TVs auch den Ton um genau dieselbe Zeit. Dumm nur, wenn die Surroundanlage ihn bereits vorher ausgibt. Über die LipSync-Optionen von HDMI zu sprechen, die dem entgegenwirken, brächte uns hier aber völlig vom Thema ab.

Jedenfalls ist es genau diese komplexe Videoverarbeitung im TV, die auch das Spielen so richtig verderben kann. Latenzzeiten von 100 bis 150 ms sind nämlich keine Seltenheit. Fast alle Hersteller haben mittlerweile die Zielgruppe der Gamer erkannt und bauen einen Spielemodus ein, der nicht nur die Farben anpasst, sondern auch Latenzzeiten minimiert. Auf anderen Geräten sollte man die Bewegungskompensation abschalten und erhält ähnliche Ergebnisse.

Messung der Latenz

Wie gesagt, haben wir uns bisher eher um die AV-Synchronität gekümmert, die Latenz aber auch grob erfassen können. Eine spezielle Testsequenz für den audiovisuellen Test der Lippensynchonität gibt es sogar auf unserer im Handel erhältlichen Blu-ray „TV- Bild perfekt einstellen“. Sie besteht aus dem Foto einer Uhr, die ihren Zeiger im Frametakt bewegt und einem Piepton, wenn er 12:00 erreicht.

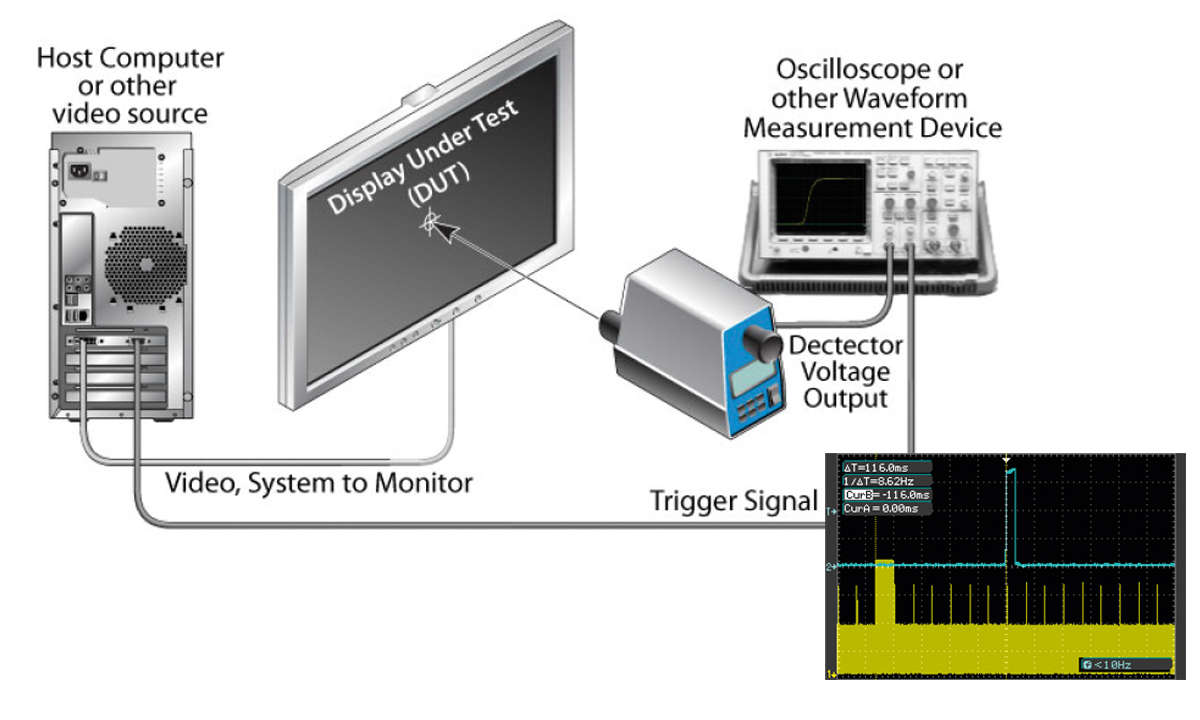

Zusätzlich leuchtet für Messungen ein kleines Quadrat parallel zum Ton auf. Schon kann man mit einem 2-Kanal-Oszilloskop, Mikrofon und Lichtsensor den Versatz zwischen Bild und Ton mikrosekundengenau bestimmen. Um zusätzlich die Latenzzeit, also die Verzögerung vom Losschicken des Bildes von Player bis zur Darstellung der Pixel auf dem Display zu berechnen, braucht man ein entscheidendes Signal: den Trigger, also einen Impuls zum Zeitpunkt, wann das Messintervall starten soll – beim Losschicken des Frames.

Wir hatten viel herumprobiert und im Groben die analogen Audio- und Videoausgänge unserer Referenzplayer als präzise Basis bestimmen können. Klappt das Herunterskalieren auf FBAS schnell und ist der Ton nicht verzögert, kommt man schon sehr gut an die reale Latenzzeit heran. Jedoch ist dieses Verfahren nicht hundertprozentig wasserdicht für dokumentierte Referenz-Labor- messungen.

Alternative PC

Oft wird als Referenz für den Input-Lag ein PC-System herangezogen, an das neben einem zu testenden HDMI-Monitor ein analoges VGA-Bildröhrengerät angeschlossen ist. Das wird dann als Referenz genutzt. Eine schnelle Zählsequenz läuft auf beiden Monitoren parallel, während ein Foto gemacht wird. Hier sind Bewertungen mit Framegenauigkeit (60Hz = 16.6 ms) möglich, natürlich unter der Vorgabe, dass beide Bilder im PC wirklich exakt parallel erzeugt werden. Wann etwas genau am HDMI-Chip anliegt und ob nicht für den Analogausgang zusätzlich umgerechnet werden muss, liegt in gewissen unbekannten Toleranzbereichen. Auch dieses Verfahren ist also nicht perfekt.

Ganz einfach

Zum inoffiziellen Standard zum Messen der Eingangsverzögerung hat sich ein kleines Gerät von Leo Bodnar gemausert. Es hat den Vorteil, dass HDMI-Generator, Messsensorik und Ausgabe des Ergebnisses in einem Gerät zusammengefasst wurden. Es sollte also zuverlässige Daten liefern, die zudem perfekt vergleichbar sind, weil mittlerweile jeder dieses preiswerte Gerät nutzt. Es misst allerdings nur in 1080p60. Ultra-HDTVs müssen also erst skalieren, was wiederum einige Millisekunden in Anspruch nehmen kann. Beim Gaming in 4K würden geringere Latenzzeiten erzielt werden.

Um das einzurechnen, nutzen einige Labors externe schnelle Scaler. Wir messen klassisch den Kino- und Game-Modus der TV-Geräte in 1080p60. Richtig spannend wird es, wenn hoffentlich ein Nachfolgegerät mit HDMI 2.1 entwickelt wird, das dann neben 4K oder 120Hz auch variable Bildraten und „Auto Low Latency Mode“ ermöglichen könnte. Hier spricht beispielsweise Samsung jetzt schon von Latenzzeiten von unter 4 Millisekunden, die man dann erstmals nachmessen können soll.

Input Lag Tester

Unter Fachmagazinen der Gaming- und TV-Branche hat sich ein kleines Gerät zum Standard für Messungen des Input-Lags entwickelt. Der portable batteriebetriebene Analysator von Leo Bodnar besitzt einen HDMI-Ausgang und einen ultraschnellen Fototransistor als Messeinheit.

Drückt man den einzigen Knopf, wird ein HDMI-Testbild (momentan nur in 1080p60) generiert und zum TV geschickt. Die Fotozelle erfasst die Helligkeit des Bereiches am Display, wo man sie hinhält. Oberer Rand, Bildmitte oder unterer Rand liefern unterschiedliche Laztenzzeiten, je nachdem, wie das Vollbild vom TV aufgebaut wird. Dann wird die Zeit vom Losschicken einer Bildfolge bis zum Aufleuchten des Panels errechnet und direkt auf dem zu testenden TV angezeigt, während schon die nächste Messung läuft. Beruhigend, dass die Abweichung von unserem alten Verfahren (oben) kleiner 10 % ist.